Cos'è un architetto di rete?

Molte delle nostre interazioni si basano sulla capacità di collegare tra loro diversi dispositivi, utilizzando complessi sistemi informatici attraverso la comunicazione di dati. Lo scambio costante di informazioni da un dispositivo all’altro avviene regolarmente sia per le attività personali che per quelle professionali. Componente fondamentale per le operazioni aziendali, le reti sono essenziali per proteggere le informazioni e garantire la privacy dei dati, aiutandoci ad accedere a varie applicazioni software e a svolgere compiti complessi ogni giorno.

Le reti forniscono la base necessaria per consentire lo scambio di informazioni in modo rapido, accurato e sicuro tra i vari dispositivi. Essendo il quadro di riferimento per le nostre attività tecnologiche, le reti devono essere progettate per soddisfare le esigenze specifiche di ogni organizzazione, ed è proprio questo che fanno gli architetti di rete. Progettano, implementano e gestiscono le reti, sia dal punto di vista del software che dell’hardware.

Compiti e responsabilità di un architetto di rete

l’architetto di rete ha la responsabilità di progettare la rete di un’organizzazione in modo specifico per raggiungere gli obiettivi aziendali delineati. Ogni rete di computer deve essere configurata in modo tale che tutti gli utenti finali possano accedere in modo sicuro ed efficiente agli strumenti necessari per svolgere il proprio lavoro. Ciò comporta anche l’implementazione della rete per soddisfare rigorosi standard di sicurezza, oltre all’installazione e alla configurazione di qualsiasi elemento hardware. Questi professionista IT deve avere una solida conoscenza di una varietà di reti, tra cui LAN (reti locali), WAN (reti geografiche) e intranet.

A che tipo di compiti devono essere preparati i professionisti IT che ricoprono il ruolo di architetto di rete?

Le mansioni e le responsabilità includono i seguenti aspetti:

- Progettare sistemi di rete per soddisfare le esigenze operative e gli standard del settore.

- Gestire l’intero processo di implementazione della rete.

- Monitorare le prestazioni della rete e adottare misure di follow-up per risolvere i problemi di latenza e di sicurezza.

- Eseguire aggiornamenti regolari della rete per creare maggiore efficienza.

- Creare backup in caso di blackout o violazione.

- Riparare l’hardware di rete difettoso o obsoleto.

- Documentare l’intero ecosistema di rete, compresi software e hardware.

- Rimanere aggiornati sui nuovi progressi per ottimizzare le prestazioni della rete.

Competenze essenziali per un ruolo di architetto di rete

La descrizione del lavoro di un architetto di rete o Network & System Architect, definizione inglese, può comprendere le seguenti competenze tecniche:

- Comprensione avanzata della progettazione dell’architettura tecnica

- Esperienza di infrastruttura di rete

- Esperienza nell’installazione e configurazione di hardware di rete

- Manutenzione di router e switch

- Gestione dell’installazione di firewall e monitoraggio continuo

- Conoscenza approfondita dei principi di sicurezza di rete e dei protocolli di cybersecurity

- Conoscenza dei bilanciatori di carico e della loro applicazione ottimale

- Conoscenza approfondita dei principi di sicurezza della rete e dei protocolli di cybersecurity

- Conoscenza dei bilanciatori di carico e della loro migliore applicazione

- Esperienza di assistenza tecnica

- Conoscenza delle reti private virtuali (VPN)

- Esperienza con il sistema dei nomi di dominio (DNS)

- Conoscenza dei framework di rete e dell’impatto dell’utilizzo di diversi tipi

- Migliori pratiche del protocollo di controllo della trasmissione/protocollo Internet (TCP/IP)

- Conoscenza di IPv6

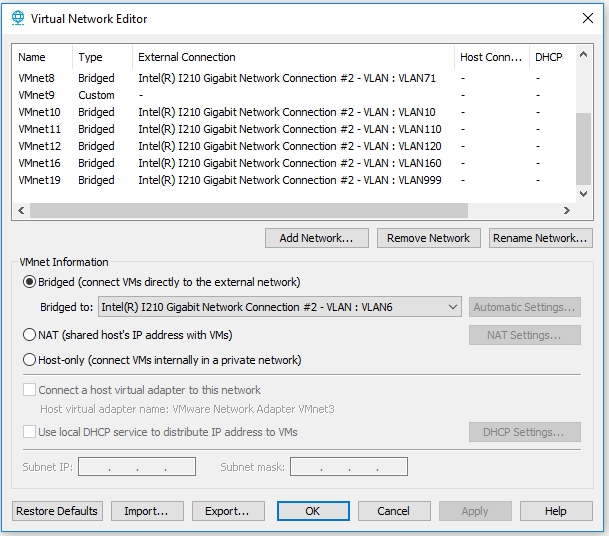

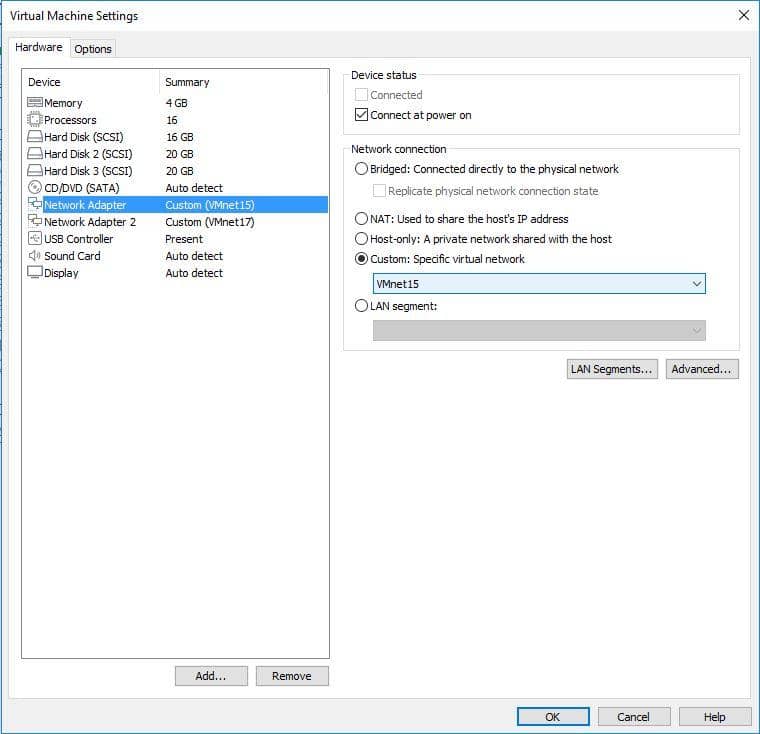

- Esperienza con la segmentazione della rete

- Conoscenza generale dello sviluppo del software e del suo impatto sulle esigenze di rete

- Conoscenza fondamentale dei sistemi operativi e del loro impatto sulla progettazione della rete

Le competenze trasversali o ``soft skills`` utili ad un Network & System Architect possono essere le seguenti:

- Forti capacità analitiche, di pensiero critico e di risoluzione dei problemi per aiutare a risolvere problemi complessi.

- Buone capacità di comunicazione per gestire il trasferimento delle conoscenze e la risoluzione dei problemi con gli utenti finali.

- Attenzione meticolosa ai dettagli nello sviluppo del progetto e della documentazione.

- Gestione efficace del team per garantire una gestione appropriata di tutte le attività e i problemi relativi alla rete.

Requisiti di istruzione e certificazione

Le conoscenze dell’architetto di rete prevedono, solitamente, la laurea. I datori di lavoro spesso cercano un’istruzione in un campo correlato, come l’informatica, le scienze informatiche, i sistemi informatici o una laurea in ingegneria. Alcune organizzazioni più piccole possono accettare un titolo di studio associato per una posizione entry-level, ma in genere è preferibile un’istruzione superiore.

Le certificazioni IT aiutano a colmare eventuali lacune nelle competenze e a dimostrare la conoscenza di aree che potrebbero non essere immediatamente evidenti data l’esperienza passata. Le certificazioni consigliate per gli architetti di rete includono:

- CompTIA Network+

- CompTIA Security+

- Certified Information Systems Security Professional (CISSP)

- Cisco Certified Internetwork Expert Routing and Switching (CCIE R&S)

- Cisco Certified Network Associate (CCNA)

- Cisco Certified Network Professional (CCNP)

- Cisco Certified Design Expert (CCDE)

- CCIE Enterprise Infrastructure Certification

- VMware Certified Professional

- VMware Certified Advanced Professional

- VMware Certified Design Expert